Künstliche Intelligenz, oder kurz KI, treibt heute viele Innovationen in der Forschung voran.

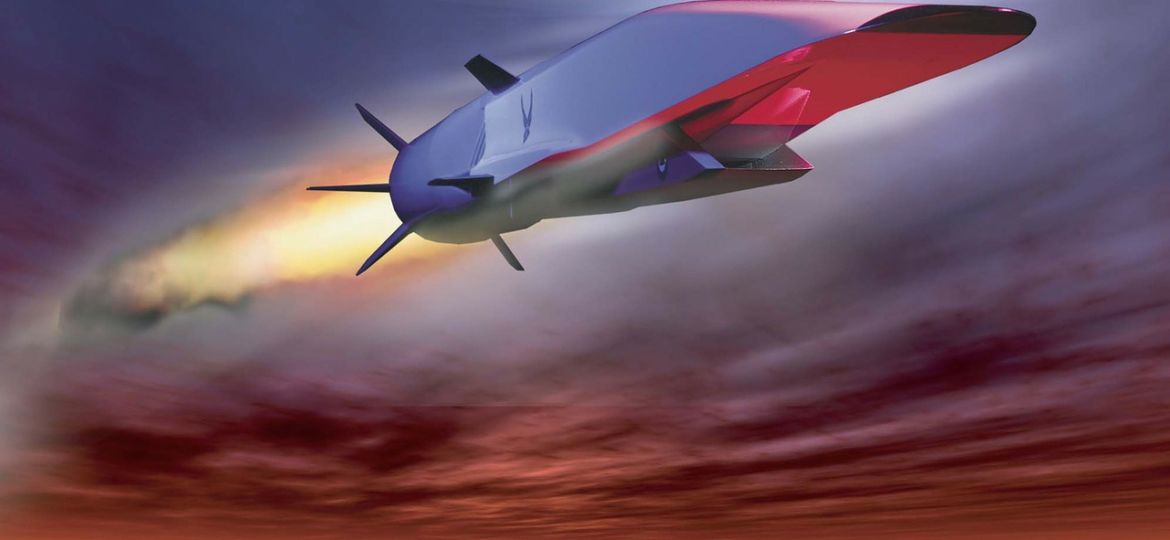

Egal ob selbstfahrende Autos, intelligente Datenbanken oder neue Produktionsroboter, in allen Bereichen des Lebens haben von KI getriebene Maschinen eine Anwendung. Doch nicht nur als Hilfe für ihre menschlichen Schöpfer, sondern auch als Kriegsmaschinen können Roboter mit KI eingesetzt werden. So kamen während der jüngsten Nahost-Konflikte der USA bereits ferngesteuerte Drohnen zum Einsatz, die feindliche Kämpfer identifizieren konnten und die Bilder an ein Entscheidungszentrum der US Streitkräfte übertragen konnten. Bisher lag die finale Entscheidung, einen Abschuss zu tätigen, noch bei ausgebildeten Soldaten der Armee. Doch es wird aktiv an einer KI geforscht, die von den Drohnen gelieferte Bilder analysiert und selbst eine Entscheidung über einen Angriff trifft. Das wirft natürlich ethische Fragen auf. Auch deshalb beschäftigt sich Hartwig von Schubert, der als Militärdekan an der Hamburger Militärakademie der Bundeswehr tätig ist, mit den ethischen Fragen bezüglich künstlicher Intelligenz.

Denn in der Zukunft könnte ein Angriff auf andere Menschen völlig von Maschinen durchgeführt werden. Als erstes würde eine unbemannte Drohne über ein umkämpftes Gebiet geschickt werden. Dort würde die Drohne Aufnahmen machen und vermeintliche Ziele aufzeichnen. Die Videos und Bilder werden dann an eine Datenbank geschickt, wo eine KI das Material auswertet. Per Gesichtsabgleich wird ein gesuchter Terrorist erkannt. Direkt nebenan befindet sich jedoch eine Grundschule. Nun muss der Computer zwischen der Eliminierung eines Ziels und der Vermeidung von unnötiger Zerstörung wählen. Kann es in dieser Situation eine „richtige“ Entscheidung geben? Ist eine KI fähig, menschlich zu handeln?

Von Schubert spricht der KI diese Fähigkeit ab.

Laut ihm sei es KIs nicht möglich Entscheidungen zu treffen, bei denen unschuldige Menschen ums Leben kommen könnten.

Roboter würden in diesen Situationen rein mathematische Entscheidungen treffen und so bereit sein, einige Kollateralschäden einzugehen. Er nennt eben jenes Beispiel: Ein gesuchter Terrorist wäre angreifbar, doch einige Kinder befinden sich in der Nähe und würden bei einem Angriff ums Leben kommen. Von Schubert ist überzeugt, dass ein Roboter diese Tode eingehen würde, um den Terroristen zur Strecke zu bringen. Sollten jedoch Menschen die Entscheidung treffen müssen, würden sie das Leben der Kinder deutlich wertvoller einschätzen, nicht zuletzt wegen dem Imageverlust des Landes und des Militärverbands, sollten Zivilisten zu Schaden kommen.

Auch seine Kollegen stimmen Von Schubert zu.

Der Konsens zwischen den führenden Militärethikern ist eindeutig: KIs sollten diese Art von Entscheidung nicht treffen. Das Wohl der Gesellschaft würde in der Hand von Computern immer vor das Wohl einzelner Menschen gestellt werden, was wohl mathematisch logisch wäre, jedoch menschlich gesehen oft nicht vertretbar wäre.

Trotz dieser kritischen Stimmen tüfteln viele Staaten an solchen autonomen Waffen. Besondern globale Superkräfte wie die USA, China oder Russland werden mit solchen Technologien immer wieder in Verbindung gebracht. Eingesetzt werden dürften diese Waffen trotzdem nicht. Die UN erlaubt diese Art der Kriegsführung momentan nicht, obwohl die oben genannten Staaten dieses Verbot aufheben wollten. Von Schubert appelliert an die fehlende Menschlichkeit der Maschinen. Trotz vorhandener Intelligenz, die mittlerweile die des Menschen übersteigen kann, seien solche Entscheidungen weiterhin Menschensache. Zu eindimensional seien die Computer, zu ethisch-fragwürdig die Entscheidungen. An Einfluss als Ratgeber im Fall solcher Entscheidungen könnten KIs dennoch gewinnen, sollten überforderte Soldaten in solchen Fällen die scheinbar allwissende KI um Hilfe fragen.